AlphaSim矫正咨询

各位老师好,我在使用SPM做双样本T检验的时候,explicit mask选用的是我的单样本T检验结果的并集MASK,这样的话最后双样本T检验的结果如果使用AlphaSim矫正的话,就不能直接使用REST slice viewer里面自带的那个表里的参数了吧?需要重新对我的并集MASK进行AlphaSim值进行评估,我想再问下 如图中,在估计AlphaSim的时候这里的P值是什么意思?估计的时候需要改吗?

如图中,在估计AlphaSim的时候这里的P值是什么意思?估计的时候需要改吗?

- Read more about AlphaSim矫正咨询

- Learner--ECNU's blog

- 2 comments

- Log in or register to post comments

- 7857 reads

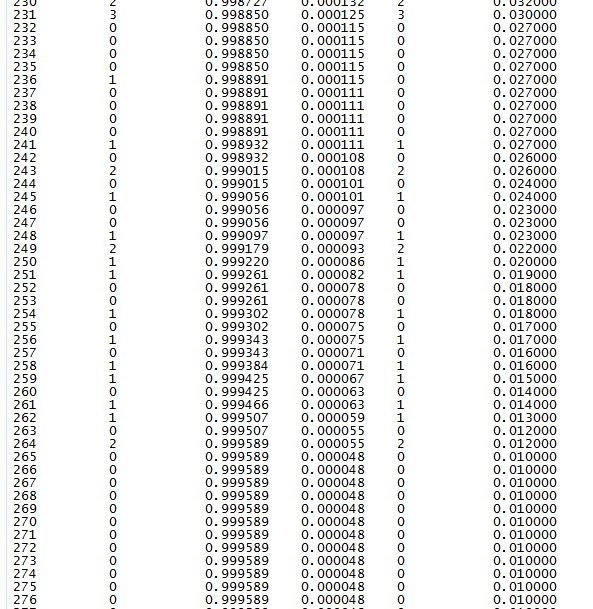

,不管是ReHo还是ALFF都这样,我估计的时候使用的MASK是软件自带的61*73*61的灰质MASK,单个体素p值是0.01,估计出来的 Cluster总是两百多,这个正常吗?之前看你的REST里面的表都是几十(虽然你讲过用预处理估计有问题,我觉得也不至于差这么多吧),请指导 下~~问题出在哪?可能。

,不管是ReHo还是ALFF都这样,我估计的时候使用的MASK是软件自带的61*73*61的灰质MASK,单个体素p值是0.01,估计出来的 Cluster总是两百多,这个正常吗?之前看你的REST里面的表都是几十(虽然你讲过用预处理估计有问题,我觉得也不至于差这么多吧),请指导 下~~问题出在哪?可能。